Pourquoi tant d’entreprises ont-elles du mal à effectuer des analyses précises et pertinentes ? Le manque de données n’est certainement pas le problème. En raison du nombre croissant d’applications dans le cloud, le volume de données explose littéralement dans les entreprises, quel que soit leur secteur d’activité. Le véritable défi ici est l’accès fiable aux données actualisées ou « fraîches » des différentes applications. Ce n’est qu’alors que les analystes de données peuvent se concentrer sur leur tâche principale – l’analyse des données.

Les entreprises de toutes tailles ont reconnu les avantages des applications SaaS. De plus en plus d’applications sont transférées dans le cloud pour gérer plus efficacement les processus d’entreprise. Pour un accès facile et fiable aux données, cela pose un problème à deux égards. D’une part, un large éventail d’applications est utilisé pour les processus transversaux, concernant plusieurs départements, tels que la gestion de la relation client, la finance et le service à la clientèle. Deuxièmement, chaque application a sa propre façon de travailler avec des API complexes et des modèles de données qui peuvent changer à tout moment, souvent de façon inattendue. Chacune de ces questions représente un énorme défi en termes d’intégration des données. Il n’est donc pas étonnant qu’avec l’essor des applications SaaS et cette complexité croissante, les entreprises ne parviennent pas à mener correctement à bien l’analyse de leurs données ni à faire progresser leur business.

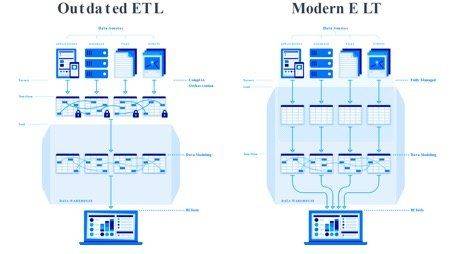

Pourquoi le processus ETL traditionnel s’essouffle-t-il ?

L’approche courante de l’intégration des données est un processus décrit comme « Extraction-Transformation-Load », appelé ETL en abrégé. L’ETL est apparu dans les années 1970, lorsque la puissance de calcul, la capacité de stockage et les débits de transmission réseau étaient faibles et coûteux. À l’ère du cloud, ces limitations n’existent plus. En raison de la puissance et du rapport coût/performance du cloud, l’ETL est devenue une méthode d’intégration des données dépassée et limitative.

L’ETL conduit à un cycle sans fin, gourmand en ressources, car chaque pipeline de données fonctionne sous son propre code individuel conçu pour un cas d’utilisation spécifique. Si le code cesse soudainement de fonctionner, cela entraîne la rupture du pipeline. Chaque fois qu’il y a un changement ou une nouvelle exigence de la part de la direction ou d’une division de l’entreprise, les ingénieurs de données doivent procéder à des révisions importantes du code.

Comment l’ETL complique le travail des analystes de données

Toutes les entreprises qui sont submergées par le flot de leurs données et qui utilisent l’ETL ne cessent de lutter et de consacrer des ressources pour garantir un accès fiable et constant à leurs informations. Malgré cela, l’ETL est toujours considéré comme un processus standard dans les entreprises traditionnelles.

Une enquête menée en juin 2020 par Dimensional Research auprès de près de 500 professionnels des données a révélé une accumulation d’opérations sujettes à des erreurs, de lacunes et de problèmes de latence des données dus à des technologies d’intégration des données obsolètes.

D’après l’enquête, les plus grands défis pour les analystes de données sont les suivants :

– 62% n’ont pas d’accès direct aux ressources d’ingénierie de données

– 90 % ont eu plusieurs sources de données non fiables au cours des 12 derniers mois.

– 86% n’ont pas accès à des données actualisées, 41% signalent que les données fournies datent même de plus de deux mois

L’approche moderne de l’intégration des données

Alors que de nombreuses entreprises continuent d’utiliser une technologie dépassée, un nombre croissant d’organisations, pour beaucoup « cloud-natives » choisissent de dire adieu à l’ETL et d’adopter une nouvelle approche. L’intégration automatisée des données, également appelée ELT automatisée, rend l’accès aux données aussi fiable et naturel que la fourniture d’électricité à partir d’une prise murale. Les analystes de données qui utilisent cette nouvelle approche associée à un ‘modern data stack’ peuvent formuler des recommandations actualisées et bien informées avec peu ou pas d’effort technique.

Comment fonctionne le processus ELT automatisé

ELT, ou « extract, load, transform », déplace l’étape de « transformation » à la fin du pipeline de données : Les analystes peuvent charger des données sans avoir à décider à l’avance des informations qu’ils souhaitent tirer de ces données hétérogènes.

Les données sources provenant de diverses applications, sous différents formats et structures de données, sont reproduites fidèlement à l’original dans un data warehouse et deviennent ainsi une « source unique de vérité ». Les analystes peuvent transformer les données en un schéma uniforme sans compromettre l’intégrité des données stockées.

L’ELT bénéficie du rapport coût/performance de la nouvelle génération de data warehouses dans le cloud, dont les architectures séparent la puissance de calcul du stockage et sont construites selon une approche orientée colonnes. Les entreprises peuvent y stocker d’énormes quantités de données et exécuter des requêtes analytiques sur ces ensembles de données de manière extrêmement efficace.

Le processus ELT automatisé utilise des connecteurs de données prêts à l’emploi qui détectent et reproduisent automatiquement les changements de schémas et d’API, et nettoie et normalise les données. Cette tâche exige une grande expertise des sources de données ainsi que des connaissances approfondies en matière de modélisation et d’analyse des données.

Un ‘modern data stack’ repose sur l’ELT et remplace les solutions traditionnelles ‘on premise’ par des technologies SaaS natives dans le cloud.

Les composants clés d’un ‘modern data stack’ sont les suivants :

1. une solution d’intégration de données automatisée, qui gère l’extraction et le chargement à partir des différentes sources.

2. un data warehouse dans le cloud

3. un outil de ‘business intelligence’

Correctement mise en œuvre, un ‘modern data stack’ permet une intégration continue des données et un accès aux données à l’échelle de l’entreprise avec un minimum d’intervention manuelle et de personnalisation du code.

Avec l’approche ETL automatisée, les entreprises peuvent charger les données sources dans leur data warehouse et les rendre directement accessibles aux analystes. Ce qui offre aux entreprises et aux analystes un haut degré de flexibilité.

L’intégration automatisée des données et un ‘modern data stack’ offrent ainsi de nombreux avantages : de la réduction des coûts d’ingénierie à l’enrichissement des données, en passant par la génération beaucoup plus rapide d’informations exploitables et une meilleure adaptation aux conditions changeantes du marché.

Processus ETL traditionnel et fonctionnement du processus ELT automatisé

Nate Spohn

VP EMEA

Fivetran